Data Warehouse im Controlling: Unterschied zwischen den Versionen

Aus ControllingWiki

Achtung. Sie nutzen eine nicht mehr unterstützte Version des Internet Explorer. Es kann zu Darstellungsfehlern kommen. Bitte ziehen Sie einen Wechsel zu einer neueren Version des Internet Explorer in Erwägung oder wechseln Sie zu einer freien Alternative wie Firefox.| [unmarkierte Version] | [Markierung ausstehend] |

| (11 dazwischenliegende Versionen von 5 Benutzern werden nicht angezeigt) | |||

| Zeile 9: | Zeile 9: | ||

| − | Um seine Hauptaufgaben, die Planung, Steuerung und Kontrolle von | + | Um seine Hauptaufgaben, die Planung, Steuerung und Kontrolle von Unternehmen zielorientiert wahrnehmen zu können und als Berater für die Geschäftsleitung zu agieren, benötigt ein Controller tiefergehende Informationen, welche zunächst aufbereitet werden müssen. Für das Vertriebscontrolling können so z.B. geplante, erreichte und prognostizierte Umsätze, oder aber auch Marktanteile der Konkurrenten und die jeweilige Marktentwicklung von Interesse sein. |

Leider sind diese Daten oftmals nicht direkt zugänglich oder verfügbar. Um an diese Daten zu kommen, wird in der Regel ein mehrstufiger Prozess angewendet, der von der Beschaffung über die Auswertung bis zur Darstellung der Daten reicht. Dieser Prozess ist auf nachfolgender Grafik dargestellt und wird im Folgenden näher beschrieben. | Leider sind diese Daten oftmals nicht direkt zugänglich oder verfügbar. Um an diese Daten zu kommen, wird in der Regel ein mehrstufiger Prozess angewendet, der von der Beschaffung über die Auswertung bis zur Darstellung der Daten reicht. Dieser Prozess ist auf nachfolgender Grafik dargestellt und wird im Folgenden näher beschrieben. | ||

| Zeile 17: | Zeile 17: | ||

Abb. 1: Data Warehouse im Zentrum eines Prozesses [2] | Abb. 1: Data Warehouse im Zentrum eines Prozesses [2] | ||

| − | |||

| − | |||

== Stufe 1: Identifizierung der Vorsysteme == | == Stufe 1: Identifizierung der Vorsysteme == | ||

| Zeile 26: | Zeile 24: | ||

Relevante Daten können sich jedoch auch in externen Quellen wieder finden, bspw. in Datenbanken von Marktforschungsinstituten oder Verbänden. Für den Controller ist es von hoher Bedeutung, die verschiedenen Datenquellen zu identifizieren und deren Potenzial zu bewerten. | Relevante Daten können sich jedoch auch in externen Quellen wieder finden, bspw. in Datenbanken von Marktforschungsinstituten oder Verbänden. Für den Controller ist es von hoher Bedeutung, die verschiedenen Datenquellen zu identifizieren und deren Potenzial zu bewerten. | ||

| − | |||

== Stufe 2: Umwandeln der Daten: der ETL-Prozess == | == Stufe 2: Umwandeln der Daten: der ETL-Prozess == | ||

| − | |||

Die Prozesse, die notwendig sind, um Daten aus einzelnen, zuvor identifizierten, opera-tiven Datenbanken in ein Data Warehouse zu integrieren, werden als Extraktions-, Transformations- und Ladeprozesse (ETL) bezeichnet. | Die Prozesse, die notwendig sind, um Daten aus einzelnen, zuvor identifizierten, opera-tiven Datenbanken in ein Data Warehouse zu integrieren, werden als Extraktions-, Transformations- und Ladeprozesse (ETL) bezeichnet. | ||

| Zeile 35: | Zeile 31: | ||

Weitere Gründe dafür, dass sich operative Daten nicht für die Analyse im Controlling eignen, sind: | Weitere Gründe dafür, dass sich operative Daten nicht für die Analyse im Controlling eignen, sind: | ||

| − | |||

• operative Daten sind transaktionsorientiert und auf Bedürfnisse des Tagesge-schäfts abgestimmt; | • operative Daten sind transaktionsorientiert und auf Bedürfnisse des Tagesge-schäfts abgestimmt; | ||

| Zeile 48: | Zeile 43: | ||

• bei Fehleingaben besteht die Gefahr des Systemstillstands operativer Systeme. | • bei Fehleingaben besteht die Gefahr des Systemstillstands operativer Systeme. | ||

| − | |||

Deshalb hat sich in der Praxis durchgesetzt, dass Controllingsoftware nicht direkt auf die operativen Vorsysteme zugreift. Vielmehr werden die Daten zunächst aus den operativen Datenbanken extrahiert. Der Datenextraktions- und Transformationsprozess gilt als anspruchsvollster Teil der Vorbereitung einer Datenanalyse (bspw. für ein umfassendes Reporting). Für das Controlling ist der ETL-Prozess damit einer der Kernprozesse für eine widerspruchsfreie, entscheidungsunterstützende Datenanalyse. | Deshalb hat sich in der Praxis durchgesetzt, dass Controllingsoftware nicht direkt auf die operativen Vorsysteme zugreift. Vielmehr werden die Daten zunächst aus den operativen Datenbanken extrahiert. Der Datenextraktions- und Transformationsprozess gilt als anspruchsvollster Teil der Vorbereitung einer Datenanalyse (bspw. für ein umfassendes Reporting). Für das Controlling ist der ETL-Prozess damit einer der Kernprozesse für eine widerspruchsfreie, entscheidungsunterstützende Datenanalyse. | ||

| − | |||

Der ETL Prozess gliedert sich in vier Stufen: | Der ETL Prozess gliedert sich in vier Stufen: | ||

| − | |||

• Filterung: Extraktion aus den Datenbeständen und Bereinigung syntaktischer und inhaltlicher Defekte | • Filterung: Extraktion aus den Datenbeständen und Bereinigung syntaktischer und inhaltlicher Defekte | ||

| Zeile 63: | Zeile 55: | ||

• Anreicherung: Bildung und Speicherung betriebswirtschaftlicher Kenngrößen | • Anreicherung: Bildung und Speicherung betriebswirtschaftlicher Kenngrößen | ||

| − | |||

Im günstigsten Fall ist so eine automatisierte Extraktion (und ein automatisches sog. Job Controlling) von Daten operativer Vorsysteme für die analytische Datenhaltung möglich. Häufig ist in der Praxis jedoch die manuelle Eingabe von Daten aus den operativen Systemen für das Controlling und die Unternehmensplanung von Nöten, man spricht hierbei auch von einem Bruch der Informationsverarbeitung. | Im günstigsten Fall ist so eine automatisierte Extraktion (und ein automatisches sog. Job Controlling) von Daten operativer Vorsysteme für die analytische Datenhaltung möglich. Häufig ist in der Praxis jedoch die manuelle Eingabe von Daten aus den operativen Systemen für das Controlling und die Unternehmensplanung von Nöten, man spricht hierbei auch von einem Bruch der Informationsverarbeitung. | ||

| − | |||

[[Bild:Abb_2.1.JPG]] | [[Bild:Abb_2.1.JPG]] | ||

| − | Abb. 2: Der ETL-Prozess mit seinen vier Teilprozessen [2] | + | Abb. 2: Der ETL-Prozess mit seinen vier Teilprozessen [2] |

| − | |||

| − | |||

== Stufe 3: Speichern der Daten im Data Warehouse == | == Stufe 3: Speichern der Daten im Data Warehouse == | ||

| − | |||

In diesem Schritt werden die für das Controlling gewonnenen und bereits umgewandelten Daten in einem Data Warehouse separat von den operativen Systemen abgespeichert. Hierbei handelt es sich exakt genommen um den letzten der ETL-Prozesse, das „Laden“ der Daten. | In diesem Schritt werden die für das Controlling gewonnenen und bereits umgewandelten Daten in einem Data Warehouse separat von den operativen Systemen abgespeichert. Hierbei handelt es sich exakt genommen um den letzten der ETL-Prozesse, das „Laden“ der Daten. | ||

Doch zunächst stellt sich die Frage, was ein Data Warehouse überhaupt ist. Ein Data Warehouse ist eine umfassende Sammlung von konsistenten, aufeinander abgestimmten (siehe ETL-Prozess), und zeitlich und nach Themen strukturierten Daten. Inmon, einer der Mitbegründer des Data Warehouse-Konzeptes, definiert ein Data Warehouse als „a subjectoriented, integrated, time variant, non-volatile collection of data in support of management decisions” [3]. | Doch zunächst stellt sich die Frage, was ein Data Warehouse überhaupt ist. Ein Data Warehouse ist eine umfassende Sammlung von konsistenten, aufeinander abgestimmten (siehe ETL-Prozess), und zeitlich und nach Themen strukturierten Daten. Inmon, einer der Mitbegründer des Data Warehouse-Konzeptes, definiert ein Data Warehouse als „a subjectoriented, integrated, time variant, non-volatile collection of data in support of management decisions” [3]. | ||

| − | |||

Die von Immon festgelegten Eigenschaften lauten im Einzelnen: | Die von Immon festgelegten Eigenschaften lauten im Einzelnen: | ||

| − | |||

• ''Subjektorientierung'': In herkömmlichen operationalen Systemen werden Daten nach funktionalen, prozessorientierten Gesichtspunkten organisiert, so z. B. für den Produktions- oder Vertriebsbereich. Im Data Warehouse hingegen orientiert sich die Datenhaltung an übergeordneten Subjekten der Unternehmung wie etwa Kunden oder Produkten, die den Erfolg der Unternehmung bestimmen. Eine Zuordnung erfolgt deshalb nach übergeordneten Gesichtspunkten, wie bspw. Kundengruppen. | • ''Subjektorientierung'': In herkömmlichen operationalen Systemen werden Daten nach funktionalen, prozessorientierten Gesichtspunkten organisiert, so z. B. für den Produktions- oder Vertriebsbereich. Im Data Warehouse hingegen orientiert sich die Datenhaltung an übergeordneten Subjekten der Unternehmung wie etwa Kunden oder Produkten, die den Erfolg der Unternehmung bestimmen. Eine Zuordnung erfolgt deshalb nach übergeordneten Gesichtspunkten, wie bspw. Kundengruppen. | ||

| Zeile 95: | Zeile 80: | ||

Data Warehouses stellen sicher, dass eine konsistente Datenbasis gewährleistet ist. Sie sind damit die derzeit wichtigste Technologie im Bereich der Integration von Manage-mentinformationen. Data Warehouses sind in Unternehmen mittlerweile weit verbreitet, unterliegen aber selbst noch einem ständigen Wandel. Für den Controller liegen damit noch eine große Gestaltungsnachfrage und ein hoher Gestaltungsdruck vor, wenn es um die Einführung neuer, vielleicht sogar konzernweiter Data Warehouses geht. Dabei steht häufig nicht mehr die Technologie im Vordergrund, da sich die meisten Anforderungen im Controlling technologisch relativ gut abbilden lassen. | Data Warehouses stellen sicher, dass eine konsistente Datenbasis gewährleistet ist. Sie sind damit die derzeit wichtigste Technologie im Bereich der Integration von Manage-mentinformationen. Data Warehouses sind in Unternehmen mittlerweile weit verbreitet, unterliegen aber selbst noch einem ständigen Wandel. Für den Controller liegen damit noch eine große Gestaltungsnachfrage und ein hoher Gestaltungsdruck vor, wenn es um die Einführung neuer, vielleicht sogar konzernweiter Data Warehouses geht. Dabei steht häufig nicht mehr die Technologie im Vordergrund, da sich die meisten Anforderungen im Controlling technologisch relativ gut abbilden lassen. | ||

Hierbei muss bspw. geklärt werden, wie das Data Warehouse richtig organisiert werden soll und wie die Datenqualität derart sichergestellt werden kann, dass die richtigen Kenngrößen abgeleitet werden können. Ebenso gewinnen rechtliche Rahmen¬be¬dingungen, wie bspw. Zugriffsregeln oder feste Speicherzeiträume im Rahmen von Compliance-Richtlinien oder dem Sarbanes-Oxley Act, an Bedeutung. | Hierbei muss bspw. geklärt werden, wie das Data Warehouse richtig organisiert werden soll und wie die Datenqualität derart sichergestellt werden kann, dass die richtigen Kenngrößen abgeleitet werden können. Ebenso gewinnen rechtliche Rahmen¬be¬dingungen, wie bspw. Zugriffsregeln oder feste Speicherzeiträume im Rahmen von Compliance-Richtlinien oder dem Sarbanes-Oxley Act, an Bedeutung. | ||

| − | |||

| − | |||

== Stufe 4: Auswerten der Daten mittels OLAP-Abfragen und Data Mining == | == Stufe 4: Auswerten der Daten mittels OLAP-Abfragen und Data Mining == | ||

| Zeile 128: | Zeile 111: | ||

| − | == Autoren == | + | == Ersteinstellende Autoren == |

| + | Prof. Dr. Thomas Hess | ||

| − | + | Christian Matt, MSc. | |

| − | + | [[Kategorie: IT]] | |

Aktuelle Version vom 30. Dezember 2015, 16:32 Uhr

Inhaltsverzeichnis

- 1 Zusammenfassung

- 2 Vier Stufen der Datenaufbereitung

- 3 Stufe 1: Identifizierung der Vorsysteme

- 4 Stufe 2: Umwandeln der Daten: der ETL-Prozess

- 5 Stufe 3: Speichern der Daten im Data Warehouse

- 6 Stufe 4: Auswerten der Daten mittels OLAP-Abfragen und Data Mining

- 7 Literaturtipps

- 8 Ersteinstellende Autoren

Zusammenfassung

Ein Data Warehouse ist eine von den operationalen Datenverarbeitungs-Systemen einer Unternehmung isolierte Datensammlung, die verschiedene unternehmensweit anfallende Daten in sich vereint und langfristig speichert. Ein derartiges Data Warehouse unterstützt den Controller, indem es strukturierte, bereinigte und verdichtete Daten als Analyse- und Entscheidungsbasis zur Verfügung stellt.

Vier Stufen der Datenaufbereitung

Um seine Hauptaufgaben, die Planung, Steuerung und Kontrolle von Unternehmen zielorientiert wahrnehmen zu können und als Berater für die Geschäftsleitung zu agieren, benötigt ein Controller tiefergehende Informationen, welche zunächst aufbereitet werden müssen. Für das Vertriebscontrolling können so z.B. geplante, erreichte und prognostizierte Umsätze, oder aber auch Marktanteile der Konkurrenten und die jeweilige Marktentwicklung von Interesse sein.

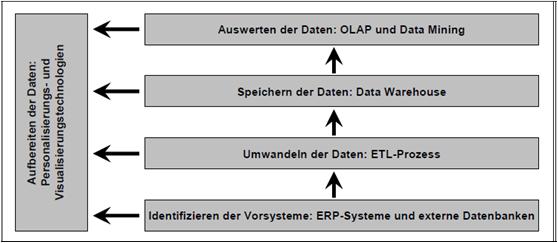

Leider sind diese Daten oftmals nicht direkt zugänglich oder verfügbar. Um an diese Daten zu kommen, wird in der Regel ein mehrstufiger Prozess angewendet, der von der Beschaffung über die Auswertung bis zur Darstellung der Daten reicht. Dieser Prozess ist auf nachfolgender Grafik dargestellt und wird im Folgenden näher beschrieben.

Abb. 1: Data Warehouse im Zentrum eines Prozesses [2]

Stufe 1: Identifizierung der Vorsysteme

Viele der eingangs erwähnten Daten sind im Unternehmen bereits vorhanden. Meist setzen Unternehmen für das Management der wichtigsten Ressourcen (wie Finanzmittel, Mitarbeiter oder Anlagen) so genannte Enterprise-Resource-Planning-Systeme (ERP-Systeme) ein. Selbst kleinere Unternehmen verfügen aber häufig über mehrere dieser Systeme. ERP-Systeme unterstützen verschiedene essentielle Funktionsbereiche eines Unternehmens, wie z.B. Marketing und Vertrieb, Controlling, Finanz- und Rechnungswesen und Produktion, und speichern die dort anfallenden Daten. Daher sind ERP-Systeme eine sehr wichtige Datenquelle für den Controller.

Relevante Daten können sich jedoch auch in externen Quellen wieder finden, bspw. in Datenbanken von Marktforschungsinstituten oder Verbänden. Für den Controller ist es von hoher Bedeutung, die verschiedenen Datenquellen zu identifizieren und deren Potenzial zu bewerten.

Stufe 2: Umwandeln der Daten: der ETL-Prozess

Die Prozesse, die notwendig sind, um Daten aus einzelnen, zuvor identifizierten, opera-tiven Datenbanken in ein Data Warehouse zu integrieren, werden als Extraktions-, Transformations- und Ladeprozesse (ETL) bezeichnet. Gerade bei Daten aus verschiedenen Quellen sollte man sein Augenmerk auf die Konsistenz der Daten richten. Konsistenz bedeutet, dass sich die einzelnen Daten nicht widersprechen, so dass bspw. für die Zuordnung einer Auszahlung nicht zwei Kostenstellen angegeben sind. Ursachen für solche Inkonsistenzen können u.a. einfache Erfassungsfehler, aber auch unterschiedliche Definitionen der Daten in den liefernden Vorsystemen sein. So führt es schon zu Problemen, wenn bspw. die Angabe der Fertigungszeit einmal ohne und einmal mit Beförderung des Werkstücks zum Lager erfolgt. Die mangelnde Konsistenz der Daten ist ein Grund, warum die Daten aus den operativen Vorsystemen in der Regel nicht direkt für Analysen im Controlling eingesetzt werden können. Ein weiteres Hindernis liegt darin begründet, dass trotz zunehmender Datenintegration oftmals unterschiedliche physische Speicherplätze der Daten vorliegen und deshalb eine Analyse über alle Daten nur unter großem Aufwand möglich ist. So müssten bei einem direkten Zugriff alle relevanten Dateien und Datenbanken für die Analyse geöffnet und gesperrt werden.

Weitere Gründe dafür, dass sich operative Daten nicht für die Analyse im Controlling eignen, sind:

• operative Daten sind transaktionsorientiert und auf Bedürfnisse des Tagesge-schäfts abgestimmt;

• es findet eine ständige Aktualisierung der Daten statt, daher sind Analysen später nicht nachvollziehbar;

• für die Analyse müssen Daten in verdichteter Form vorliegen;

• operative Systeme sind optimiert für Standardeingaben und Abfragen;

• komplexe Analysen können Rechenleistungen beeinträchtigen und operative Systeme blockieren (Ressourcenbelastung) und

• bei Fehleingaben besteht die Gefahr des Systemstillstands operativer Systeme.

Deshalb hat sich in der Praxis durchgesetzt, dass Controllingsoftware nicht direkt auf die operativen Vorsysteme zugreift. Vielmehr werden die Daten zunächst aus den operativen Datenbanken extrahiert. Der Datenextraktions- und Transformationsprozess gilt als anspruchsvollster Teil der Vorbereitung einer Datenanalyse (bspw. für ein umfassendes Reporting). Für das Controlling ist der ETL-Prozess damit einer der Kernprozesse für eine widerspruchsfreie, entscheidungsunterstützende Datenanalyse.

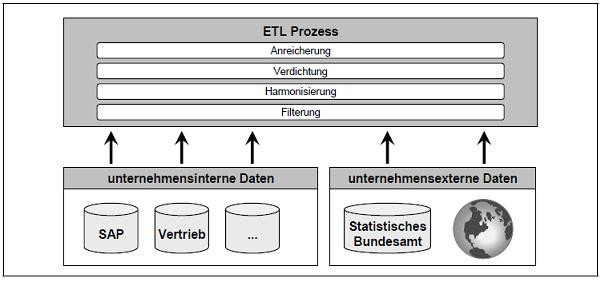

Der ETL Prozess gliedert sich in vier Stufen:

• Filterung: Extraktion aus den Datenbeständen und Bereinigung syntaktischer und inhaltlicher Defekte

• Harmonisierung: Syntaktische und betriebswirtschaftliche Abstimmung der gefilterten Daten

• Verdichtung bzw. Aggregation: Zusammenfassung gefilterter und harmoni-sierter Daten

• Anreicherung: Bildung und Speicherung betriebswirtschaftlicher Kenngrößen

Im günstigsten Fall ist so eine automatisierte Extraktion (und ein automatisches sog. Job Controlling) von Daten operativer Vorsysteme für die analytische Datenhaltung möglich. Häufig ist in der Praxis jedoch die manuelle Eingabe von Daten aus den operativen Systemen für das Controlling und die Unternehmensplanung von Nöten, man spricht hierbei auch von einem Bruch der Informationsverarbeitung.

Abb. 2: Der ETL-Prozess mit seinen vier Teilprozessen [2]

Stufe 3: Speichern der Daten im Data Warehouse

In diesem Schritt werden die für das Controlling gewonnenen und bereits umgewandelten Daten in einem Data Warehouse separat von den operativen Systemen abgespeichert. Hierbei handelt es sich exakt genommen um den letzten der ETL-Prozesse, das „Laden“ der Daten.

Doch zunächst stellt sich die Frage, was ein Data Warehouse überhaupt ist. Ein Data Warehouse ist eine umfassende Sammlung von konsistenten, aufeinander abgestimmten (siehe ETL-Prozess), und zeitlich und nach Themen strukturierten Daten. Inmon, einer der Mitbegründer des Data Warehouse-Konzeptes, definiert ein Data Warehouse als „a subjectoriented, integrated, time variant, non-volatile collection of data in support of management decisions” [3].

Die von Immon festgelegten Eigenschaften lauten im Einzelnen:

• Subjektorientierung: In herkömmlichen operationalen Systemen werden Daten nach funktionalen, prozessorientierten Gesichtspunkten organisiert, so z. B. für den Produktions- oder Vertriebsbereich. Im Data Warehouse hingegen orientiert sich die Datenhaltung an übergeordneten Subjekten der Unternehmung wie etwa Kunden oder Produkten, die den Erfolg der Unternehmung bestimmen. Eine Zuordnung erfolgt deshalb nach übergeordneten Gesichtspunkten, wie bspw. Kundengruppen.

• Integration: Die aus den operativen Vorsystemen übernommenen Daten müssen im Data Warehouse hinsichtlich unterschiedlicher Dimensionen, wie bspw. Bezeichnung oder Format, integriert werden, was gerade bei heterogenen, über Jahre gewachsenen Systemen schwierig sein kann. Eine Integration über verschiedene Landesgesellschaften einer Unternehmung hinweg kann die Komplexität weiter erhöhen; man denke hier nur an verschiedene Terminologien und die notwendige sprachliche Anpassung. Ziel der Datenintegration ist eine vollständige, korrekte und widerspruchsfreie Speicherung der Daten. Die Datenintegrität muss dabei kontinuierlich durch verschiedene Integritätsregeln überwacht werden.

• Dauerhaftigkeit: Im Gegensatz zu operativen Informationssystemen, bei denen die Daten kontinuierlich geändert werden, werden die im Data Warehouse eingestellten Daten nach einer fehlerfreien Übernahme nicht mehr verändert. Die auf dem Data Warehouse aufbauenden Datenanalysen sind dadurch jederzeit reproduzierbar. Die dauerhafte und konsistente Speicherung der Daten im Data Warehouse ist im Controlling von besonderer Bedeutung, da Analysen immer auf einer einheitlichen Analysebasis durchgeführt werden müssen.

• Zeitraumbezug: Die Daten sind zeitlich strukturiert, das bedeutet, dass die durch den ETL-Prozess gewonnenen Daten mit einem Zeitstempel versehen werden. Dieser Zeitstempel findet sich nicht in den zugrunde liegenden Daten. So ist bspw. später nachvollziehbar, wie sich die Einstufung der Zahlungsmoral bestimmter Kunden im Zeitablauf verändert hat. In operationalen Systemen würde dagegen nur die aktuelle Einstufung gespeichert werden. Ebenso ist denkbar, dass Lieferanteninformationen im operationalen System bereits gelöscht sind, diese aber für Analysen im Data Warehouse noch vorgehalten werden. Während in ERP-Systemen aktuelle Daten also immer wieder verändert werden können und keine Dokumentation der Historie stattfindet, ist der Zeitbezug im Controlling für Zeitreihenvergleiche sehr wichtig. Hier werden Daten und Informationen benötigt, die die Entwicklung des Unternehmens über einen Zeitraum repräsentieren, um Trends zu erkennen und zu untersuchen.

Data Warehouses stellen sicher, dass eine konsistente Datenbasis gewährleistet ist. Sie sind damit die derzeit wichtigste Technologie im Bereich der Integration von Manage-mentinformationen. Data Warehouses sind in Unternehmen mittlerweile weit verbreitet, unterliegen aber selbst noch einem ständigen Wandel. Für den Controller liegen damit noch eine große Gestaltungsnachfrage und ein hoher Gestaltungsdruck vor, wenn es um die Einführung neuer, vielleicht sogar konzernweiter Data Warehouses geht. Dabei steht häufig nicht mehr die Technologie im Vordergrund, da sich die meisten Anforderungen im Controlling technologisch relativ gut abbilden lassen. Hierbei muss bspw. geklärt werden, wie das Data Warehouse richtig organisiert werden soll und wie die Datenqualität derart sichergestellt werden kann, dass die richtigen Kenngrößen abgeleitet werden können. Ebenso gewinnen rechtliche Rahmen¬be¬dingungen, wie bspw. Zugriffsregeln oder feste Speicherzeiträume im Rahmen von Compliance-Richtlinien oder dem Sarbanes-Oxley Act, an Bedeutung.

Stufe 4: Auswerten der Daten mittels OLAP-Abfragen und Data Mining

Eine zunehmend wichtige Aufgabe des Controllers ist es, Daten im Unternehmen auszuwerten und mit Hilfe von Personalisierungstechnologien für sich und für das Management das richtige Bündel an Informationen bereit zu stellen. Zur Unterstützung dieser Auswertungsaufgabe stehen mittlerweile verschiedene Technologien zur Verfügung, von denen vor allem OLAP und Data Mining zu nennen sind.

Gerade in großen Data Warehouse-Umgebungen stoßen einfache Abfrage-Werkzeuge für den Datenzugriff an die Grenzen der Leistungsfähigkeit. Für komplexere analytische Abfragen können OLAP-Anwendungen genutzt werden. Bei OLAP handelt es sich um eine mehrdimensionale Methode zur Beschreibung, Verarbeitung und Analyse von Daten, die den Controller damit bei analytischen und planerischen Aufgaben unterstützt. Dabei soll eine problemorientierte Sichtweise auf das Datenmaterial mit betriebswirtschaftlichen Dimensionen eingenommen werden. Aus diesem Grund wird ein Datenbankverwal-tungssystem mit mehrdimensionaler Analysefunktionalität eingesetzt, die es dem Anwender erlaubt, mittels eines interaktiven Zugriffs eine Vielzahl von Sichten und Darstellungsweisen auf Basisdaten zu erhalten. Ein typisches Anwendungsbeispiel ist die umfassende Analyse der Vertriebsleistung z. B. einer Versicherung, bei der Ist und Soll nach Regionen, Produkten und Vertriebswegen untersucht wird. OLAP-Systeme erlauben hierbei die flexible Auswertung unterschiedlichster Kombinationen. Für die tägliche Arbeit im Controlling spielt die Funktionalität von OLAP-Systemen daher eine wichtige Rolle.

Data Mining hingegen beschäftigt sich mit der Identifikation und Extraktion bisher unbekannter Zusammenhänge aus großen Datenbeständen. Mittels statistischer Verfahren wird hier hypothesenfrei vorgegangen, um nach Mustern, Auffälligkeiten oder Besonderheiten zu suchen. So können frühzeitig Veränderungen erkannt und ent-sprechende Gegenmaßnahmen eingeleitet werden.

Data Mining bedient sich hierbei der Methodenansätze aus der Statistik, der künstlichen Intelligenz, dem maschinellen Lernen und der Mustererkennung. Eine Prämisse des erfolgreichen Einsatzes von Data Mining sind große digitale Datenbestände, die aufgrund ihrer internen Struktur eine gewisse Komplexität aufweisen, die es nicht zulässt, Muster und Strukturen mit dem bloßen Auge zu erfassen. Die Prämisse großer Datenmengen ist zumindest für das Controlling großer Unternehmen gewährleistet. Hinsichtlich des Nutzens von Data Mining ergibt sich jedoch je nach Controllingbereich ein unterschiedliches Bild. Während im klassischen Controlling die der Datenbasis zugrunde liegenden Strukturen in der Regel übersichtlich und bekannt sind, und daher überraschende neue Erkenntnisse eher unwahrscheinlich erscheinen, so ergibt sich für das Vertriebscontrolling und für das Controlling von Kundenbeziehungen verstärktes Potential.

Gerade bei größeren, komplexen Unternehmen, die in verschiedenen Bereichen und auf mehreren Märkten vertreten sind, ist es durchaus denkbar, dass einem Standard-Reporting der Umsatzrückgang eines Produktes einer Region, der durch ein ganz bestimmtes Zusammenspiel von Erzeugnisbereich, Vertretergruppe, Kundengruppe sowie zeitlichem und regionalen Bezug zu erklären ist, verborgen bleibt. In dem komplexen Geflecht potenziell interessanter mehrelementiger Datenbezüge können erkenntnisbringende Ursache-Wirkung-Beziehungen aufgrund fehlender Transparenz untergehen. In den letzten Jahren haben sich diese Technologien zur Auswertung großer Datenberge zu stabilen Systemen mit hohem Einsatznutzen weiterentwickelt. Ziel dieser Technologien ist es, der Datenflut entgegenzuwirken bzw. die Informationen, die für eine Organisation relevant sind, zu identifizieren und sinnvoll aufzubereiten. Derartige Systeme mit Auswertungstechnologien setzen üblicherweise auf einem Data Warehouse auf. Dies muss aber nicht immer der Fall sein, da eine Auswertung und Analyse von Daten auch auf der operativen Basis erfolgen könnte. Aus Gründen wie Datenintegrität und historischer Datenhaltung, wird in der Regel jedoch ein Data Warehouse als Auswertungsbasis genutzt. Besonders im Controlling mit Themen wie Abweichungsanalysen, Soll-/Ist-Vergleichen oder Trendanalysen, ist die Nutzung eines Data Warehouses als Basis für Auswertungstechnologien nahezu unumgänglich.

Literaturtipps

[1]Gluchowski, P.; Gabriel, R.; Dittmar, C.: Management Support Systeme und Business Intelligence: Computergestützte Informationssysteme für Fach- und Führungskräfte, 2., vollständig überarbeitete Aufl., Berlin u. a. 2008.

[2]Hess, T.: IT-Basics für Controller, Stuttgart 2006.

[3]Inmon, W.H. (1992): Building the Data Warehouse, Wellesley.

Ersteinstellende Autoren

Prof. Dr. Thomas Hess

Christian Matt, MSc.